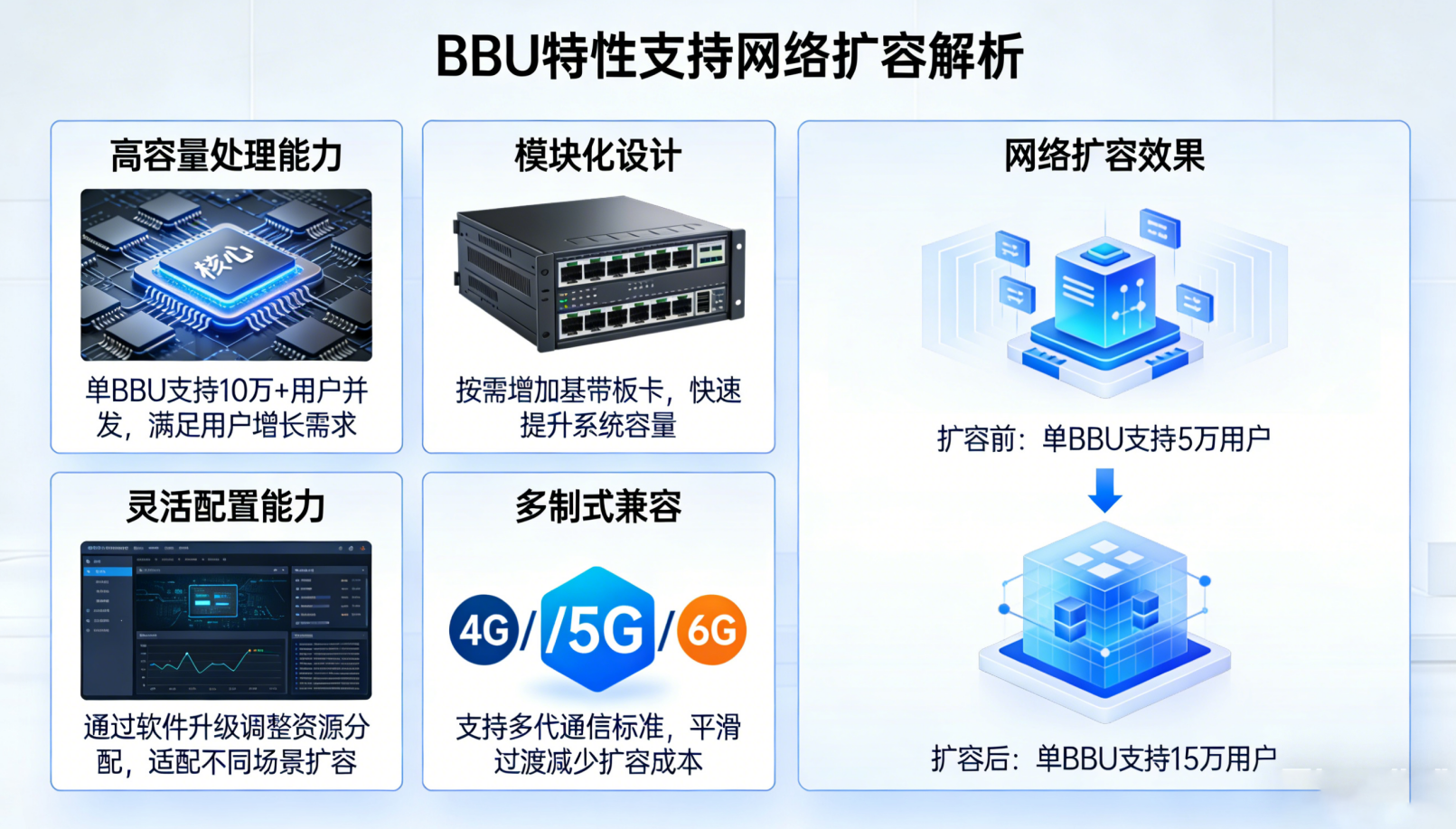

Conception matérielle modulaire de la BBU pour une évolutivité verticale et horizontale

Les équipements de communication modernes reposent sur des architectures d’unités de bande de base (BBU) prenant en charge deux stratégies d’évolutivité complémentaires : l’évolutivité verticale — qui consiste à renforcer chaque unité individuelle avec une puissance de traitement accrue — et l’évolutivité horizontale — qui consiste à déployer davantage de nœuds BBU au sein du réseau afin de répartir la charge et d’accroître la capacité.

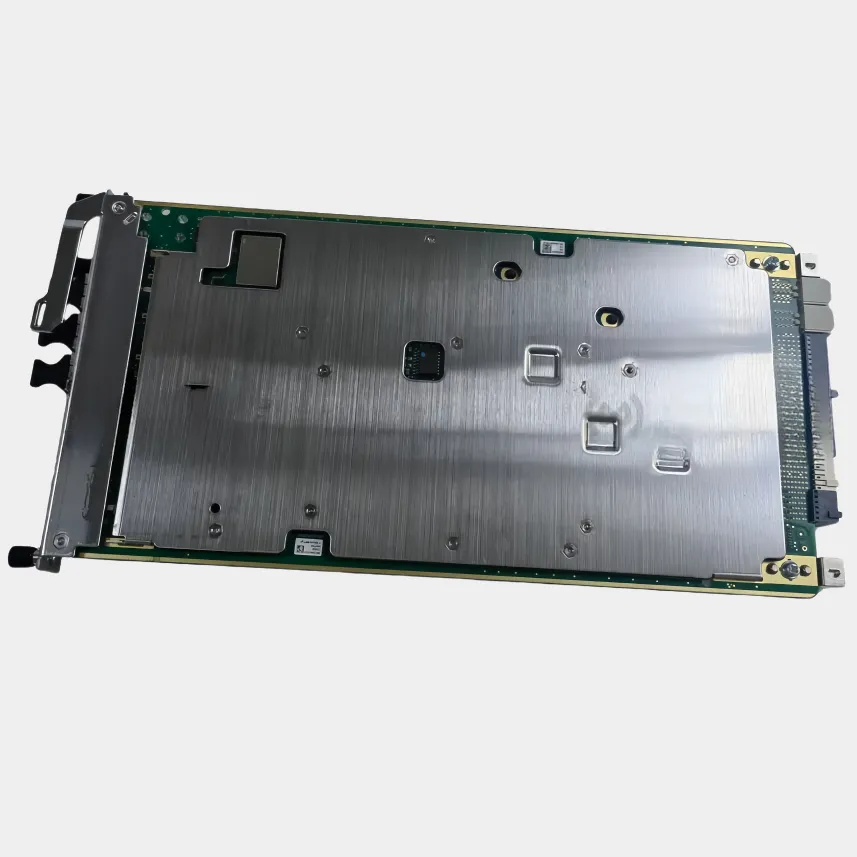

Modules interchangeables à chaud et flexibilité du châssis pour une croissance incrémentale de la capacité

Les opérateurs peuvent désormais remplacer ou installer des composants matériels, tels que des cartes processeur et des unités d’interface radio, sans interrompre les services, grâce à des modules remplaçables sur site qui prennent en charge l’échange à chaud. Quel avantage ? Une extension rapide de la capacité, dès que nécessaire. Il suffit de brancher une nouvelle carte processeur pour voir le débit augmenter d’environ 40 % presque instantanément. Les conceptions modernes de châssis sont équipées d’emplacements standard et de systèmes de bus arrière adaptables, compatibles avec tous types de modules, notamment des accélérateurs de chiffrement et des interfaces de fronthaul. Cette souplesse permet aux entreprises de concevoir exactement ce dont elles ont besoin, sans être contraintes d’utiliser du matériel provenant d’un seul fournisseur, tout en économisant un espace précieux dans les baies. Des essais industriels ont montré que ces fonctionnalités d’échange à chaud réduisent les temps d’arrêt liés à la maintenance d’environ 90 % par rapport aux anciens systèmes, dont tous les composants étaient fixes dès la mise en service.

Extension CPU/FPGA/GPU et optimisation de la bande passante mémoire pour les charges de travail intensives en calcul

Les unités de bande de base modernes (BBU) doivent répondre à la fois aux exigences de la 5G-Advanced et aux spécifications Open RAN, ce qui les amène à intégrer différents types de puissance de calcul. Par exemple, les circuits intégrés programmables sur site (FPGA) prennent en charge les tâches de traitement du signal ultra-rapides, où chaque microseconde compte. Les unités de traitement graphique (GPU) interviennent quant à elles pour faire fonctionner l’intelligence artificielle dans des domaines tels que le balayage de faisceaux (beamforming) ou la gestion des interférences. Enfin, les unités centrales de traitement (CPU) multi-socket gèrent l’ensemble des opérations du plan de contrôle et orchestrent discrètement tous les processus. En ce qui concerne la mémoire, les fabricants adoptent les technologies DDR5 et HBM3, capables de transférer des données à des débits supérieurs à 1 téraoctet par seconde. Une telle bande passante est absolument indispensable pour soutenir des systèmes MIMO (Multiple Input Multiple Output) à grande échelle et répondre aux exigences de traitement en temps réel du fronthaul. Certains optimisations ingénieuses rendent cela possible : par exemple, la partition de l’espace cache afin que les fonctions critiques de bande de base ne soient pas ralenties, l’allocation intelligente de la mémoire entre les différents sockets selon les principes NUMA (Non-Uniform Memory Access), ainsi qu’une compression matérielle intégrée qui réduit le trafic sur le lien fronthaul d’environ 35 %. L’ensemble de ces composants, travaillant en synergie, permet de maintenir une latence inférieure à 5 millisecondes tout en assurant des performances robustes de la nouvelle radio 5G (5G NR), même lorsque les sites cellulaires traitent en continu des flux de données atteignant 200 gigabits par seconde.

Intégration de la BBU avec un réseau natif du cloud et programmable (SDN/NFV)

Découplage du plan de contrôle et orchestration dynamique via une gestion de la BBU activée par SDN

La définition logicielle des réseaux (SDN, pour Software Defined Networking) modifie la manière dont nous gérons les unités de bande de base (BBU) en séparant les fonctions de contrôle du traitement effectif des données. Cela donne lieu à un système dans lequel des contrôleurs intelligents assurent la majeure partie du traitement décisionnel de façon centralisée, tout en permettant aux BBU elles-mêmes de prendre localement des décisions concernant l’acheminement des données et la gestion des ressources radio. Grâce à des interfaces de programmation d’applications (API) ouvertes, les opérateurs réseau peuvent désormais ajuster dynamiquement l’allocation du spectre, basculer entre différentes méthodes de modulation selon les besoins, et rééquilibrer la charge de travail entre les secteurs cellulaires en fonction de l’évolution en temps réel du trafic. Lorsque la charge augmente fortement pendant les heures de pointe, ces systèmes SDN entrent presque instantanément en action, redirigeant la capacité réseau loin des zones surchargées sans nécessiter de configuration manuelle. Résultat ? Moins de temps d’arrêt et moins de soucis pour les techniciens. Selon un rapport sectoriel récent publié en 2024, les entreprises ayant adopté cette approche constatent généralement une réduction d’environ un tiers de leurs coûts globaux de gestion réseau par rapport aux méthodes plus anciennes, fondées principalement sur des dispositifs individuels.

Fonctions de bande de base virtualisées et gestion automatisée du cycle de vie avec la NFV

La virtualisation des fonctions réseau, ou NFV pour faire court, transforme la manière dont les entreprises de télécommunications exploitent leur infrastructure. Au lieu de dépendre de coûteux équipements propriétaires de BBU (Baseband Unit), les opérateurs exécutent désormais les fonctions de bande de base sur des serveurs standards disponibles dans le commerce. Des fonctions telles que le traitement du signal, le codage de canal et les protocoles de couche 2 fonctionnent toutes sous forme de fonctions réseau virtuelles légères ou d’alternatives natives du cloud. L’ensemble du système est géré automatiquement via des plateformes telles que Kubernetes et ONAP, qui prennent en charge tout, de la configuration initiale à l’adaptation dynamique des ressources selon les besoins, en passant par la résolution des problèmes et l’application des correctifs, le tout depuis des tableaux de bord centralisés. Lorsqu’un pic soudain de trafic se produit, ces systèmes NFV peuvent rapidement créer des copies de BBUs virtuelles et les répartir sur différents groupes de serveurs. Et lorsque la demande diminue, ils désactivent simplement les ressources inutilisées afin de réduire la consommation d’énergie. Selon les résultats de l’étude « Cloud RAN Benchmark » menée l’année dernière, cette approche flexible permet de réduire les coûts d’investissement d’environ moitié, tout en maintenant une disponibilité quasi parfaite de 99,999 %. Ce qui distingue véritablement la NFV, toutefois, c’est la rapidité avec laquelle les mises à jour sont déployées : les entreprises peuvent ainsi diffuser de nouvelles fonctionnalités à des milliers d’emplacements en quelques minutes seulement, au lieu d’attendre plusieurs semaines, ce qui accélère les cycles d’innovation sans interrompre les services offerts aux clients.

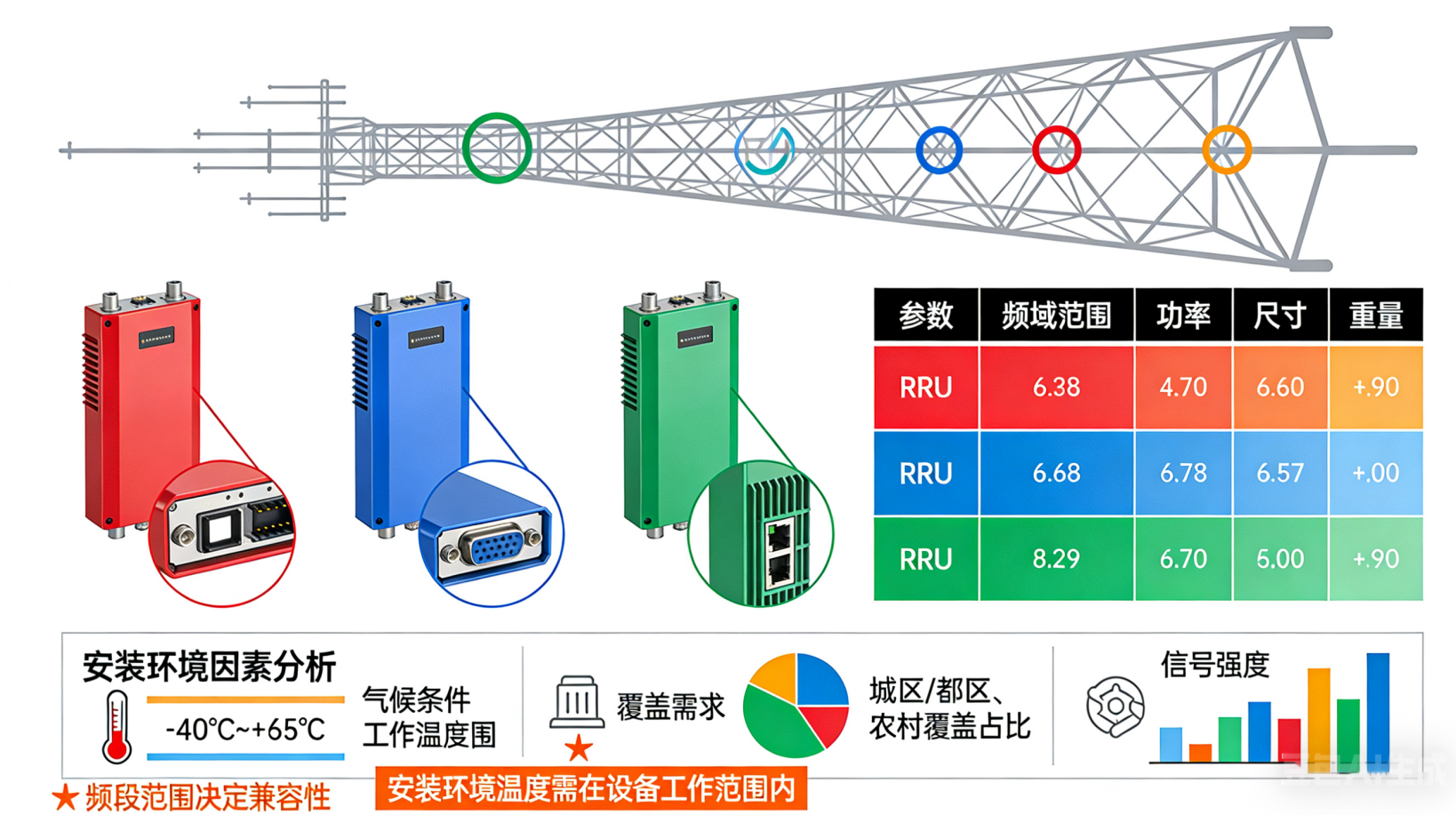

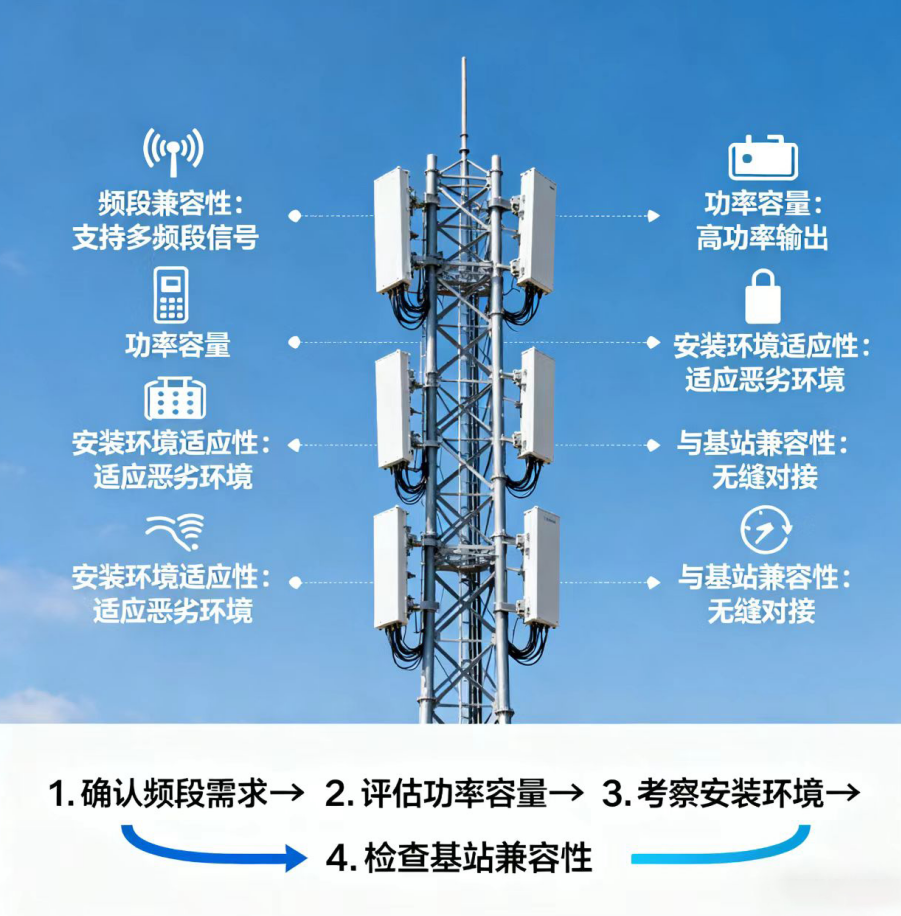

Facteurs de forme des BBU sensibles au déploiement et alignement de l'infrastructure

Configurations de BBU en mode Sidecar par rapport à celles montées en rack pour les architectures vRAN distribuées et centralisées

Le choix du bon facteur de forme de la BBU est très important pour adapter la conception matérielle aux modalités de déploiement et aux contraintes existantes au niveau de l'infrastructure. Les BBUs de type « sidecar » sont de petites unités économes en énergie, installées directement à côté des antennes sur site. Elles réduisent la latence du signal, ce qui les rend particulièrement adaptées aux applications nécessitant des connexions extrêmement fiables et à faible délai, telles que les services URLLC ou les tâches de calcul en périphérie (edge computing) dans des architectures vRAN étendues. À l’inverse, les BBUs montées en baie regroupent l’ensemble du traitement de bande de base au sein de nœuds centraux. Cette approche permet de réduire l’espace requis, parfois jusqu’à 40 %, et simplifie également la gestion de la dissipation thermique, des alimentations de secours et des opérations d’entretien courant. La plupart des opérateurs réseau privilégient les versions montées en baie, car elles offrent une meilleure évolutivité et permettent le partage des ressources entre différentes zones. N’oubliez toutefois pas les versions « sidecar » ! Elles continuent de jouer un rôle essentiel là où l’espace disponible est limité ou dans des emplacements difficiles d’accès. Dans tous les cas, ces deux solutions s’intègrent parfaitement aux technologies SDN et NFV, assurant ainsi une interconnexion fluide au sein des réseaux modernes basés sur le cloud.

Optimisation des ressources pilotée par l’IA au sein de grappes évolutives de BBU

L'intelligence artificielle a transformé la façon dont nous gérons les grappes de BBU, en passant d'une simple réaction aux problèmes à une approche proactive et adaptable. Des indicateurs clés de performance en temps réel — tels que les niveaux de trafic, le nombre d'utilisateurs connectés simultanément, l'efficacité d'utilisation du spectre et les données de surveillance matérielle — alimentent des systèmes d'apprentissage automatique. Ces systèmes peuvent prédire les besoins en capacité jusqu'à 48 heures à l'avance, ce qui permet ensuite de faire évoluer automatiquement, à la hausse ou à la baisse, les fonctions de baseband virtuelles selon les besoins. Des techniques spécialisées d'apprentissage par renforcement améliorent continuellement la répartition de la puissance de calcul entre les différentes parties du réseau, ainsi que la gestion de la bande passante et des paramètres d'alimentation. Cette approche réduit la consommation d'énergie superflue d'environ 22 %, car elle désactive intelligemment les équipements peu sollicités. En matière d'équilibrage des charges entre serveurs, l'automatisation permet d'augmenter le taux d'utilisation global d'environ 30 %. Cela simplifie grandement l'extension des pools de BBU à mesure que le trafic 5G continue de croître. Le résultat obtenu est, en somme, une infrastructure capable de s'autoréparer : elle évite aux entreprises d'acheter excessivement du matériel dès le départ, maintient la latence sous les 5 millisecondes pour les applications critiques et gère les pics imprévus de trafic sans nécessiter d'intervention manuelle.

Table des Matières

- Conception matérielle modulaire de la BBU pour une évolutivité verticale et horizontale

- Intégration de la BBU avec un réseau natif du cloud et programmable (SDN/NFV)

- Facteurs de forme des BBU sensibles au déploiement et alignement de l'infrastructure

- Optimisation des ressources pilotée par l’IA au sein de grappes évolutives de BBU