垂直および水平スケーリングに対応したモジュラー式BBUハードウェア設計

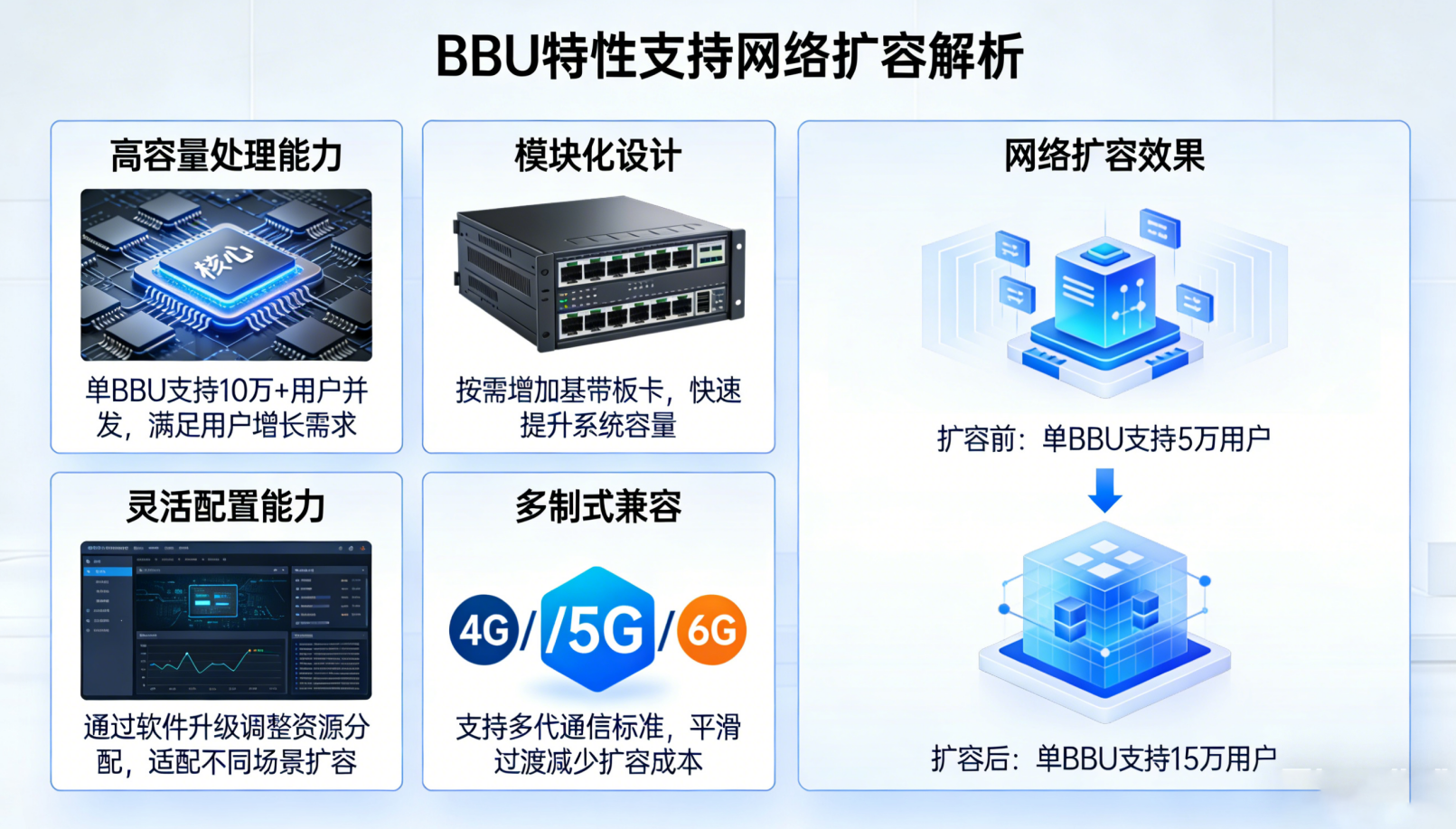

現代の通信機器は、2つの補完的なスケーリング戦略に対応するベースバンドユニット(BBU)アーキテクチャに依存しています。すなわち、個々のユニットに追加の処理能力を付与する「垂直スケーリング」と、ネットワーク上に複数のBBUノードを展開して負荷を分散・容量を増加させる「水平スケーリング」です。

段階的な容量増強を実現するホットスワップ可能なモジュールと柔軟なシャーシ設計

運用者は、サービスを停止することなく、プロセッサカードや無線インターフェースユニットなどのハードウェア構成要素を交換または追加装着できるようになりました。これは、ホットスワップをサポートするフィールド交換可能なモジュール(FRU)によるものです。その利点とは?必要に応じた迅速な容量拡張です。新しいプロセッサカードを差し込むだけで、スループットがほぼ即座に約40%向上します。最新のシャーシ設計では、標準スロットおよびさまざまなモジュール(例:暗号化アクセラレータ、フロントホールインターフェースなど)に対応した柔軟なバックプレーンシステムが採用されています。この柔軟性により、企業は自社のニーズに完全に合致するシステムを構築でき、特定ベンダーの機器に縛られることもありません。さらに、貴重なラックスペースの節約にも貢献します。業界テストによると、これらのホットスワップ機能を備えたシステムは、初日からすべてが固定された従来型システムと比較して、保守によるダウンタイムを約90%削減できます。

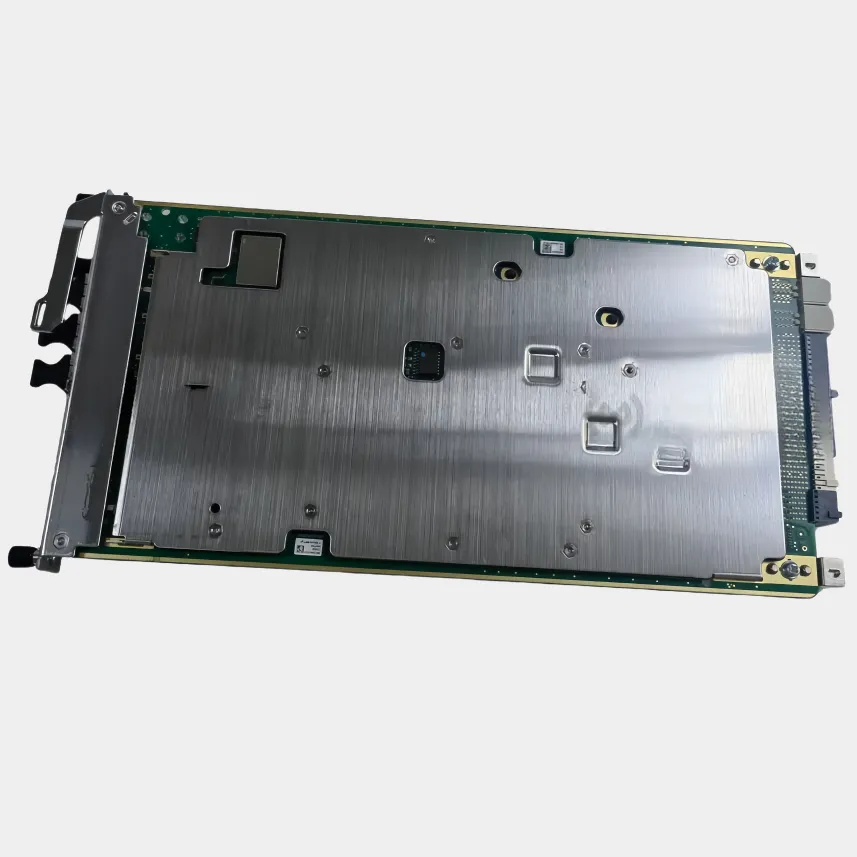

計算負荷の高いワークロード向けCPU/FPGA/GPU拡張およびメモリ帯域幅最適化

最新のベースバンドユニット(BBU)は、5G-Advancedの要件とOpen RAN仕様の両方に対応する必要があるため、異なる種類の計算処理能力を統合しています。例えば、フィールドプログラマブルゲートアレイ(FPGA)は、マイクロ秒単位の速度が求められる超高速な信号処理タスクを担当します。グラフィックス処理ユニット(GPU)は、ビームフォーミングや干渉問題への対応など、AIを活用した処理においてその力を発揮します。また、マルチソケット型の中央演算処理装置(CPU)は、すべての制御プレーン操作を管理し、裏側で全体を調整・統括しています。メモリに関しては、メーカー各社がDDR5およびHBM3技術を採用しており、データ転送速度は1テラバイト/秒を超えるレベルに達しています。このような帯域幅は、大規模なマルチプルインプット・マルチプルアウトプット(MIMO)システムをサポートし、リアルタイムのフロントホール処理要求に応えるために絶対不可欠です。さらに、こうした性能を実現するための巧妙な最適化も導入されています。たとえば、キャッシュ領域を分割して、重要なベースバンド機能が処理遅延を招かないようにする、NUMA(Non-Uniform Memory Access)の原則に基づき、異なるソケット間でメモリを賢く割り当てる、そしてハードウェア内蔵の圧縮機能によりフロントホールトラフィックを約35%削減するといったものです。これらのコンポーネントが連携して動作することで、セルサイトが200ギガビット/秒という継続的なデータ流量を処理している状況下でも、遅延を5ミリ秒未満に抑え、堅牢な5G New Radio(NR)パフォーマンスを維持しています。

クラウドネイティブおよびプログラマブルネットワーキング(SDN/NFV)とのBBU統合

SDN対応BBU管理によるコントロールプレーンの分離および動的オーケストレーション

ソフトウェア定義ネットワーキング(SDN)は、制御機能と実際のデータ処理を分離することにより、ベースバンドユニット(BBU)の管理方法を変革します。これにより、スマートコントローラーが中央で大部分の判断・制御を担う一方で、BBU自体がデータ転送や無線リソース管理といったローカルな意思決定を実行できるシステムが構築されます。オープンなアプリケーションプログラミングインターフェース(API)が利用可能であるため、ネットワーク事業者はリアルタイムで周波数帯域の割り当てを調整したり、必要に応じて異なる変調方式間を切り替えたり、リアルタイムのトラフィック状況に基づいてセルセクター間の負荷バランスを動的に再配分したりすることが可能になります。ラッシュアワーなどトラフィックが集中する時間帯には、これらのSDNシステムがほぼ即座に作動し、手動での設定変更を必要とせずに、過負荷状態にあるエリアからネットワーク容量を自動的に再配分します。その結果、ダウンタイムが減少し、技術者による対応負荷も大幅に軽減されます。2024年に発表された業界レポートによると、この手法を導入した企業では、従来の個別デバイスに依存した管理方式と比較して、ネットワーク全体の管理コストが約3分の1削減される傾向が見られます。

仮想化ベースバンド機能およびNFVによる自動ライフサイクル管理

ネットワーク機能仮想化(NFV:Network Functions Virtualization)は、通信事業者がインフラを運用する方法を変革しています。高価な専用BBUハードウェアに依存する代わりに、事業者は現在、市販の汎用サーバー上でベースバンド機能を実行しています。信号処理、チャネル符号化、およびLayer 2プロトコルなども、軽量な仮想ネットワーク機能(VNF)またはクラウドネイティブな代替ソリューションとして動作します。全体のシステムは、KubernetesやONAPなどのプラットフォームによって自動的に管理され、構成設定から必要に応じたスケーリング、障害対応、パッチ適用まで、すべて中央集約型のダッシュボードから一元的に実施されます。トラフィックが急増した際には、これらのNFVシステムが迅速に仮想BBUのコピーを作成し、異なるサーバーグループ間で分散展開できます。また、需要が減少した場合には、不要なリソースを単にシャットダウンして電力消費を削減します。昨年の「Cloud RAN Benchmark」調査結果によると、この柔軟なアプローチにより、資本支出(CapEx)が約半分に削減され、同時に99.999%というほぼ完璧な稼働率(アップタイム)を維持しています。ただし、NFVが特に際立つ点は、アップデートの展開速度です。企業は新機能を数分以内に数千か所の拠点に展開でき、これまで数週間かかっていたプロセスを大幅に短縮できます。これにより、顧客サービスの中断を招くことなく、より迅速なイノベーションサイクルを実現できます。

展開を意識したBBUフォームファクターおよびインフラストラクチャーの整合性

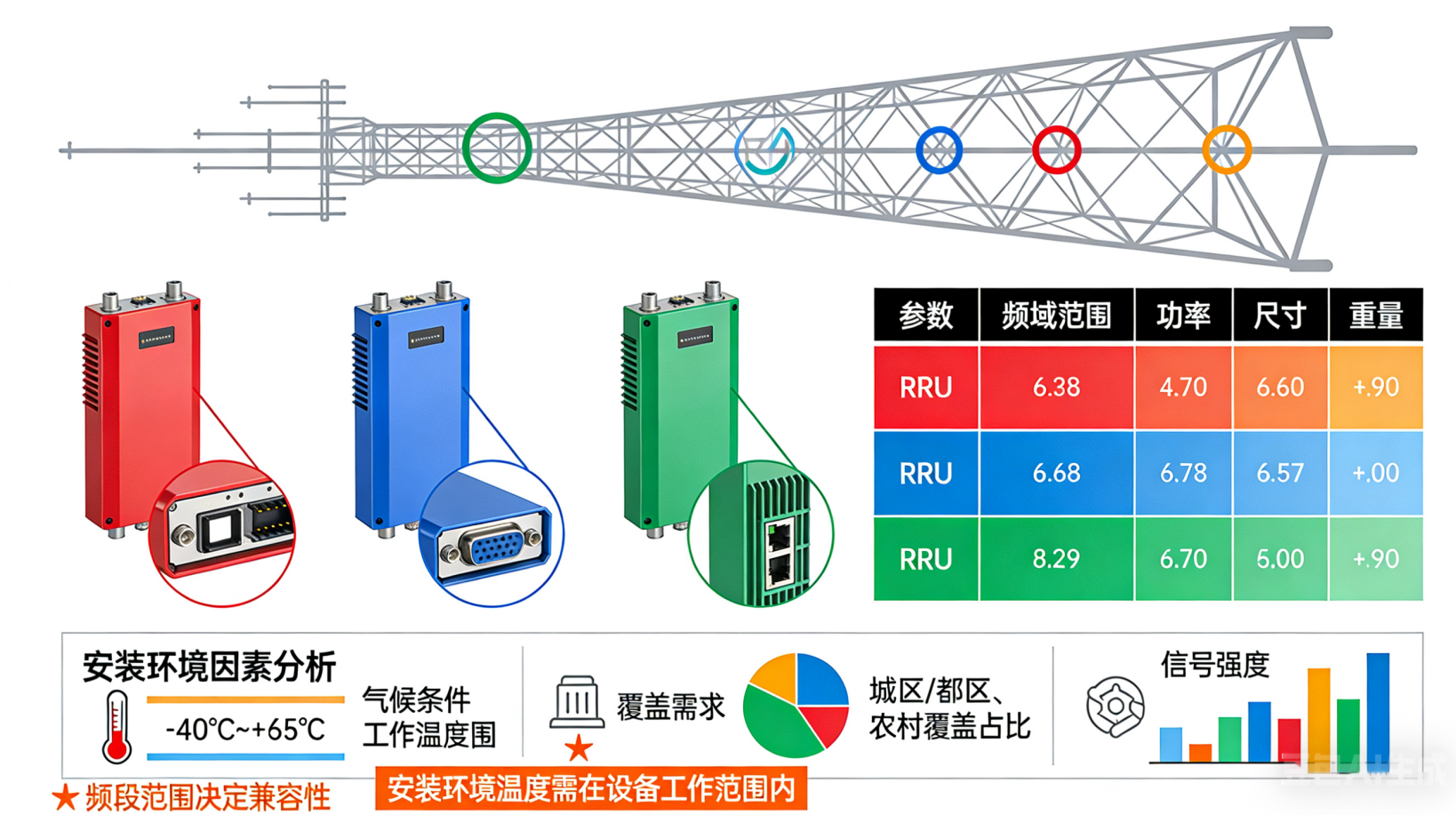

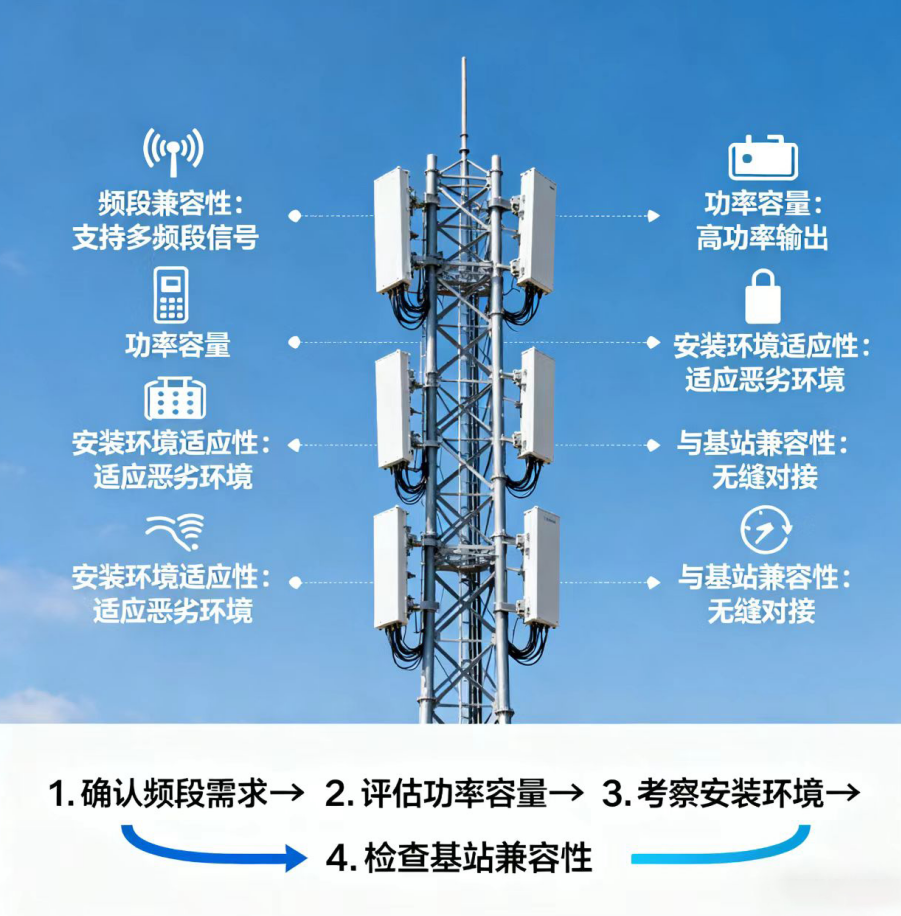

分散型および集中型vRAN向けのサイドカーアーキテクチャとラックマウント型BBU構成の比較

正しいBBUフォームファクタを選択することは、ハードウェア設計を展開方法およびインフラストラクチャにおける制約に適合させる上で非常に重要です。サイドカーバリューユニット(Sidecar BBU)は、現場のアンテナのすぐ隣に設置される小型でエネルギー効率の高いユニットです。これにより信号遅延が低減され、URLLCサービスや分散型vRAN構成におけるエッジコンピューティングなどの、極めて信頼性が高く、最小限の遅延が求められるアプリケーションに最適です。一方、ラックマウント式BBUは、ベースバンド処理を中央ハブに集約します。この方式では、設置スペースを最大で約40%削減でき、放熱管理、バックアップ電源の運用、および定期点検も大幅に容易になります。大多数のネットワーク事業者は、スケーラビリティが高く、異なるエリア間でリソースを共有できるという利点から、ラックマウント式を採用しています。ただし、サイドカーユニットも見過ごしてはなりません!設置スペースが限られている場所や、アクセスが困難な場所において、依然として不可欠な役割を果たしています。いずれの方式も、SDNおよびNFV技術と良好に連携し、現代のクラウドベースネットワーク内でのシームレスな統合を実現します。

AI駆動のリソース最適化(スケーラブルなBBUクラスター全体)

人工知能(AI)は、BBUクラスターの管理方法を変革し、問題が発生してからの対応から、予測的かつ適応的な運用へと移行させました。トラフィック量、同時接続ユーザー数、周波数帯域の利用効率、ハードウェア監視データといったリアルタイムの主要業績評価指標(KPI)が機械学習システムに供給されます。これらのシステムは、最大48時間先までの必要容量を予測し、その予測に基づいて仮想ベースバンド機能(vBBU)を自動的にスケールアップまたはスケールダウンします。また、特別な強化学習技術により、ネットワーク内の異なる構成要素間における計算リソースの配分、帯域幅および電力設定の管理が継続的に最適化されています。このアプローチにより、使用頻度の低い機器を賢く電源オフすることで、エネルギーの無駄を約22%削減できます。サーバー間のワークロードバランス調整においても、自動化によって全体のリソース利用率が約30%向上します。これにより、5Gトラフィックの継続的な増加に伴うBBUプールの拡張が大幅に容易になります。結果として得られるのは、いわば「自己修復型」のインフラストラクチャーです。企業は初期段階で過剰な機器を購入する必要がなくなり、重要なアプリケーションに対しては遅延を5ミリ秒未満に抑え、また突発的なトラフィック急増にも、人的介入なしで自動的に対応できます。