Kernfunktion optischer Transceiver in Hochgeschwindigkeitsnetzwerken

Elektrisch-optische Konvertierung und Erhaltung der Signalintegrität

Optische Transceiver fungieren als Bindeglied zwischen elektrischer Netzwerktechnik und den dünnen Glasfasern. Diese kleinen Arbeitstiere wandeln elektrische Signale mithilfe von Laserdioden in Lichtimpulse um und kehren diesen Vorgang am anderen Ende wieder um, wo Fotodetektoren das Licht empfangen und es erneut in elektrische Signale zurückverwandeln. Diese bidirektionale Übertragung ermöglicht es uns, riesige Datenmengen mit beeindruckender Geschwindigkeit über Glasfasernetzwerke zu senden. Die Sauberkeit und Integrität dieser Signale ist von entscheidender Bedeutung. Daher setzen Hersteller auf hochentwickelte Verfahren wie die PAM4-Modulation in Kombination mit Digitalen Signalprozessoren (DSP). Diese Technologien bekämpfen Phänomene wie Signalausbreitung (Dispersion), Signalverlust (Dämpfung) sowie zahlreiche nichtlineare Effekte, die die Übertragung stören können. Selbst bei extrem hohen Übertragungsraten von 400 Gbit/s und darüber hinaus gelingt es diesen Systemen, Bitfehler nahezu vollständig zu vermeiden. Stellen Sie sich vor, wie unsere Rechenzentren und KI-Anwendungen ohne eine derart präzise elektro-optische Ingenieursleistung aussehen würden: Wir müssten ewig auf den Abschluss großer Datentransfers warten.

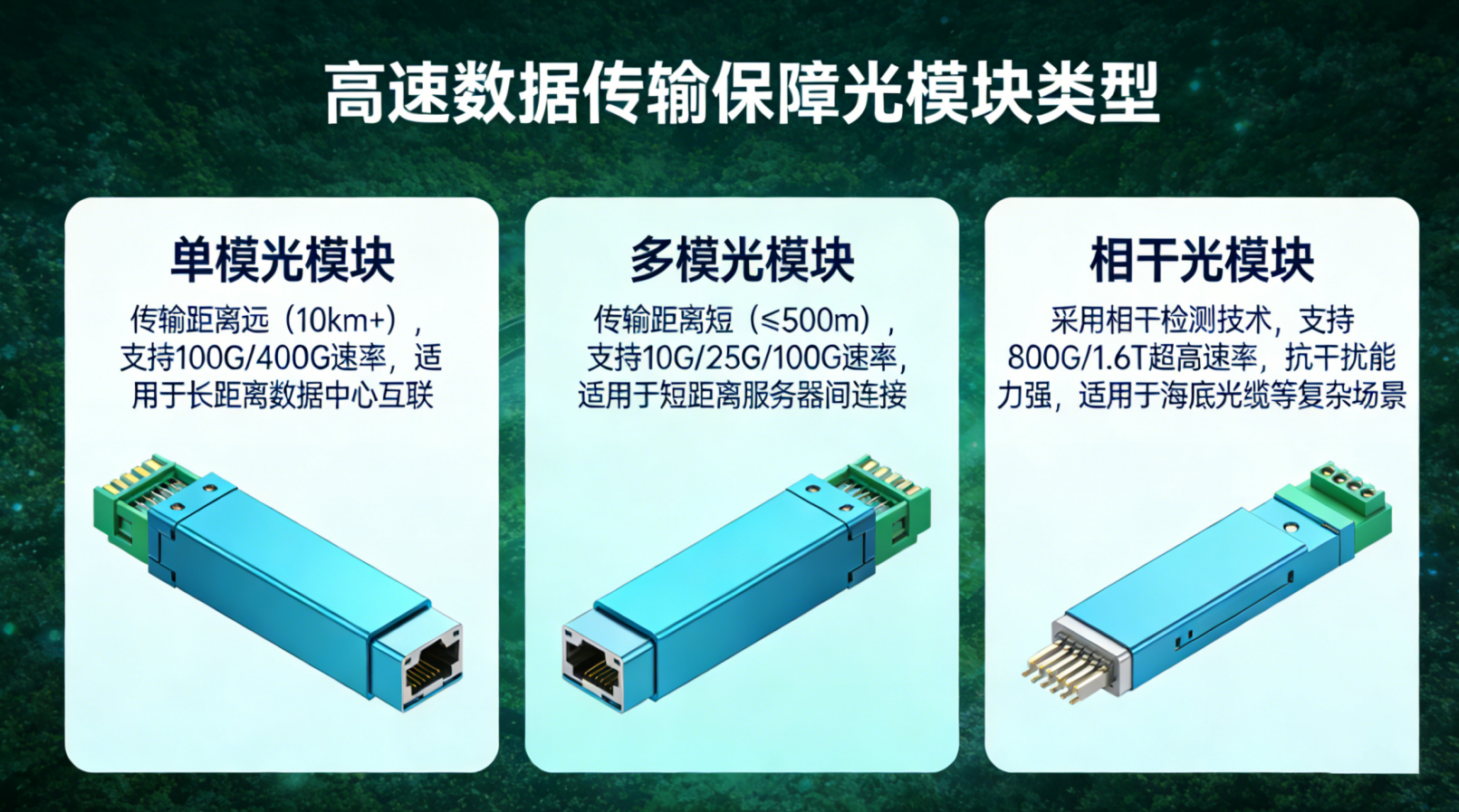

Wie Wellenlänge, Datenrate und Entfernung sich gegenseitig beeinflussen, um die Leistung zu definieren

Die Leistung und Machbarkeit des Einsatzes von Transceivern hängen tatsächlich von drei zentralen Faktoren ab, die gemeinsam wirken: Wellenlänge, Datenrate und Entfernung. Bei der Wahl der Wellenlänge spielt die Kompatibilität mit den jeweiligen Fasertypen eine große Rolle. Für kürzere Distanzen wird üblicherweise 850 nm mit Multimode-Faser eingesetzt, wodurch beispielsweise 100G über etwa 100 Meter übertragen werden können. Für längere Strecken greifen Ingenieure dagegen auf 1550 nm mit Einmodenfaser zurück, mit der sich 400G-Signale über Entfernungen von bis zu rund 2 Kilometern übertragen lassen. Wenn die Datenraten von 400G bis hin zu 800G steigen, führt kein Weg an kohärenter Optik oder an den anspruchsvollen PAM4-Signalisierungstechniken vorbei. Dies hat jedoch einen Preis: einen erhöhten Stromverbrauch sowie eine größere Anfälligkeit gegenüber Störungen im Übertragungspfad. Auch der Faktor Entfernung setzt strikte Grenzen: Die meisten 80-km-Verbindungen erreichen aufgrund von chromatischer Dispersion und sinkenden Rauschpegeln lediglich ein Maximum von 200G. Umgekehrt können kürzere 10-km-Verbindungen tatsächlich 800G-Geschwindigkeiten bewältigen, sofern geeignete Verfahren zur Vorwärtsfehlerkorrektur (FEC) sowie Kompensation durch digitale Signalverarbeitung (DSP) eingesetzt werden. Netzwerkplaner in der Praxis investieren viel Zeit in das Abwägen dieser konkurrierenden Anforderungen, wenn sie Systeme entwerfen, die skalierbar sein und sich im Laufe der Zeit an die sich wandelnden Marktanforderungen anpassen müssen.

Kritische Komponenten für moderne optische Transceiver

Laserdioden, Fotodetektoren und DSPs: Für Geschwindigkeit und Genauigkeit

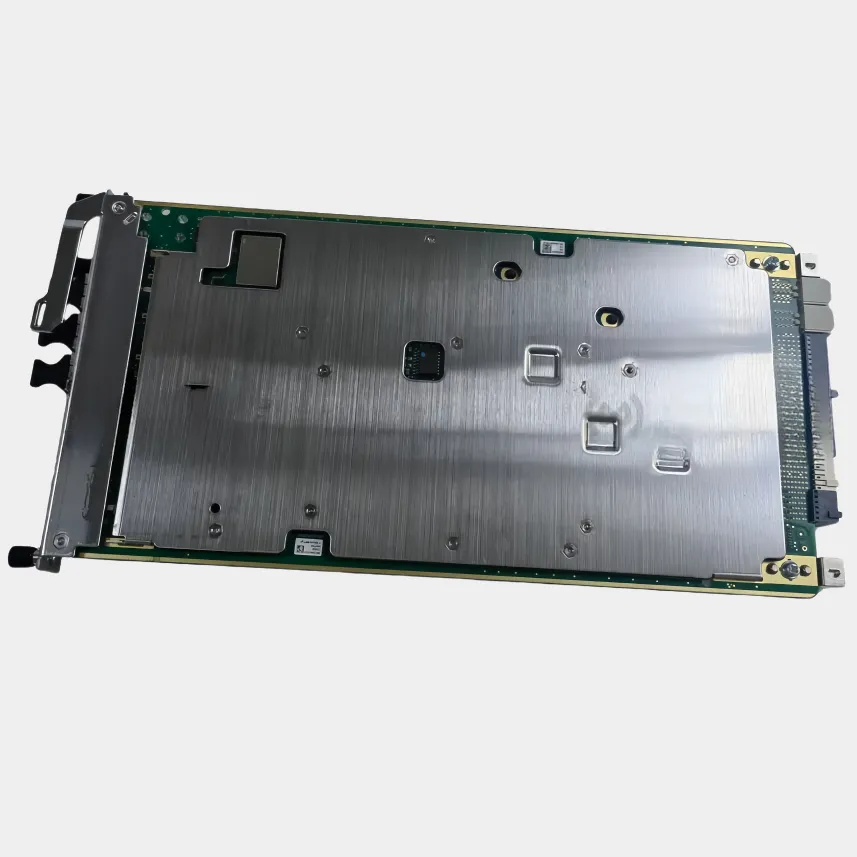

Heutige optische Transceiver basieren auf drei Hauptkomponenten, die zusammenarbeiten: Laserdioden, Fotodetektoren und jene fortschrittlichen Digitalen Signalprozessoren, die wir als DSPs bezeichnen. Die Laserdioden erzeugen stabile, schnelle optische Signale – meist mittels verteilter Rückkopplungstechnologie oder neuerer Siliziumphotonik-Systeme –, wodurch Signalverluste bei der Datenübertragung über Glasfaserkabel minimal gehalten werden. Bei den Fotodetektoren setzen die meisten Systeme entweder PIN- oder Avalanche-Typen ein, um das eingehende Licht wieder in klare elektrische Signale umzuwandeln. Diese Detektoren müssen äußerst reaktionsschnell sein und gleichzeitig das Rauschniveau niedrig halten, damit die Daten unbeschädigt bleiben. Die DSPs übernehmen dann im Hintergrund zahlreiche komplexe Aufgaben wie die Echtzeit-Entzerrung von Signalen, die Wiederherstellung der Taktsynchronisation sowie die Decodierung von FEC-Korrekturen, um während der Übertragung auftretende Störungen zu beheben. Alle diese Komponenten arbeiten nahtlos zusammen, um selbst über Entfernungen von mehr als 100 Kilometern hinweg beeindruckende Bitfehlerraten unter 1E–15 zu erreichen. Und vergessen wir nicht die Anforderungen an deterministische Latenzzeiten, die diese Systeme unverzichtbar für den Betrieb moderner hyperskaliger Rechenzentren und zur Unterstützung unserer wachsenden 5G-Netzinfrastruktur machen.

Die 400-G+-Effizienz-Herausforderung: Leistung, Wärme und Bandbreite in Einklang bringen

Das Überschreiten der 400-G-Schwelle verursacht gravierende Probleme im Hinblick auf Wärmeentwicklung und Stromverbrauch. Jedes Mal, wenn sich die Datenraten verdoppeln, steigen die Leistungsanforderungen um rund 60 bis 70 Prozent, wodurch mehr Wärme in jenen dicht bestückten Switch-Ports entsteht. Wird diese zusätzliche Wärme nicht kontrolliert, führt sie zu Signalverzerrungen, beschleunigtem Verschleiß von Komponenten und letztlich zu einer verringerten Systemzuverlässigkeit. Die Branche hat mehrere Ansätze entwickelt, um diese Probleme anzugehen: Einige Hersteller integrieren Mikrokanal-Kühlkörper, andere setzen adaptive Energiemanagementsysteme ein, die den Energieverbrauch bei geringem Datenverkehr um etwa 30 Prozent senken können. Zudem gewinnt die Siliziumphotonik-Technologie zunehmend an Verbreitung – sie verkürzt die langen elektrischen Verbindungen zwischen Komponenten und reduziert sowohl Signalverluste als auch Wärmeentwicklung. Auf Materialseite sind ebenfalls Fortschritte zu verzeichnen: Laser aus Indiumphosphid weisen eine höhere Wandwirkungsgrad-Effizienz im Vergleich zu herkömmlichen Alternativen auf. All diese Fortschritte bedeuten, dass moderne Transceiver bis zu 400 Watt pro Rack-Einheit bewältigen können, während ihre Innentemperatur unter 50 Grad Celsius bleibt – ein Wert, der die thermischen Standards der IEEE und der OIF für einen kontinuierlichen Hochgeschwindigkeitsbetrieb erfüllt.

Formfaktoren und Standards: Abstimmung von optischen Transceivern auf die Infrastrukturbedürfnisse

Die Auswahl des richtigen Formfaktors gewährleistet eine optimale Portdichte, ein effizientes thermisches Management sowie Interoperabilität über sich weiterentwickelnde Infrastrukturen hinweg. Standardisierte mechanische und elektrische Schnittstellen – von SFP bis QSFP-DD – ermöglichen Plug-and-Play-Kompatibilität und unterstützen gleichzeitig schrittweise Bandbreiten-Upgrades, ohne dass ein kompletter Systemaustausch erforderlich ist.

SFP, QSFP, OSFP und QSFP-DD – Skalierung von Dichte und Geschwindigkeit von 1 G bis 800 G

SFP-Module eignen sich hervorragend für die Bereitstellung von Übertragungsgeschwindigkeiten im Bereich von 1 G bis 10 G in kompakten Gehäuseformaten, die sich besonders gut für Edge-Netzwerke und Zugangspunkte eignen, an denen Platz knapp ist. Dann gibt es die QSFP-Versionen, die vier Übertragungskanäle zusammenfassen und daher für Geschwindigkeiten bis zu 100 G geeignet sind – ideal für die stark verdichteten Switches, wie sie in den meisten modernen Cloud-Rechenzentren eingesetzt werden. Für die Zukunft stehen sowohl das OSFP- als auch das QSFP-DD-Format bereit, um die enormen Bandbreitenanforderungen von 400 G bis hin zu sogar 800 G zu bewältigen – dank ihrer achtkanaligen Architektur sowie verbesserter Wärmemanagement-Lösungen. Diese neueren Designs ermöglichen tatsächlich eine Verdopplung der Anzahl an Ports pro Rack-Einheit im Vergleich zu älteren QSFP28-Standards. Laut jüngsten Erkenntnissen der OFC 2023 hat diese Entwicklung den Energieverbrauch pro Gigabit um rund 30 % gesenkt, was es Unternehmen deutlich erleichtert, von ihrer bestehenden 100-G-Infrastruktur auf diese hochmodernen 800-G-Systeme umzusteigen, die speziell für KI- und maschinelles-Lernen-Anwendungen optimiert sind.

SR, LR, ER, ZR, DR, FR: Entschlüsselung der Reichweitenstandards für den Einsatz im realen Betrieb

Die Reichweitenklassifizierungen helfen dabei, festzulegen, was wir von verschiedenen Fasertypen über verschiedene Distanzen erwarten können. Kurzreichweite (SR) eignet sich für Entfernungen unter 300 Metern mit Multimode-Faser, die häufig zum Verbinden von Geräten innerhalb von Racks oder zwischen Gebäuden auf einem Campus eingesetzt wird. Langreichweite (LR) ermöglicht größere Entfernungen bis zu 10 Kilometern über Monomode-Faser und ist daher ideal für stadtweite Netzwerkkonfigurationen. Erweiterte Reichweite (ER) reicht noch weiter bis etwa 40 km, während Langstrecke (ZR) bis zu 80 km umfasst. Diese größeren Reichweiten erfordern leistungsstärkere Laser und verbesserte Fehlerkorrekturverfahren, um in Backbone-Netzwerken und Unterseekabeln ordnungsgemäß zu funktionieren. In jüngerer Zeit sind zudem Data-Center-Reichweite (DR) und Fiber-Reichweite (FR) als spezialisierte Kategorien für moderne Rechenzentren hinzugekommen. DR deckt typischerweise Verbindungen über 500 Meter zwischen Servern in Spine-Leaf-Architekturen ab, während FR standardisierte Spezifikationen bereitstellt, die gemäß den IEEE-802.3-Richtlinien mit verschiedenen Fasertypen kompatibel sind und so die Interoperabilität zwischen Geräten verschiedener Hersteller sicherstellen.