Podstawowa funkcja transceiverów optycznych w sieciach wysokiej prędkości

Konwersja sygnału elektrycznego na optyczny oraz zachowanie integralności sygnału

Transceivery optyczne działają jako pośrednicy między urządzeniami sieciowymi pracującymi na sygnałach elektrycznych a cienkimi niciami szkła, które nazywamy światłowodami. Te małe pracownice przekształcają sygnały elektryczne w impulsy światła za pomocą diod laserowych, a następnie odwracają cały proces po drugiej stronie, gdzie fotodetektory odbierają światło i ponownie przekształcają je w sygnały elektryczne. Dzięki tej dwukierunkowej komunikacji możemy przesyłać ogromne ilości danych przez sieci światłowodowe z niewiarygodną prędkością. Zachowanie czystości i integralności tych sygnałów ma ogromne znaczenie. Dlatego producenci polegają na zaawansowanych technikach, takich jak modulacja PAM4 w połączeniu z procesorami sygnału cyfrowego (DSP). Te technologie zwalczają zjawiska takie jak rozmywanie sygnału (dyspersja), tłumienie sygnału (atenuacja) oraz różnego rodzaju nieliniowe efekty, które mogą zakłócać transmisję. Nawet przy błyskawicznych prędkościach 400 Gb/s i wyższych te systemy zapewniają prawie zerową liczbę błędów bitowych. Wyobraź sobie, jak wyglądałyby nasze centra danych i operacje związane z sztuczną inteligencją bez tak precyzyjnego inżynierii elektro-optycznej — czekalibyśmy wiecznie na zakończenie dużych transferów danych.

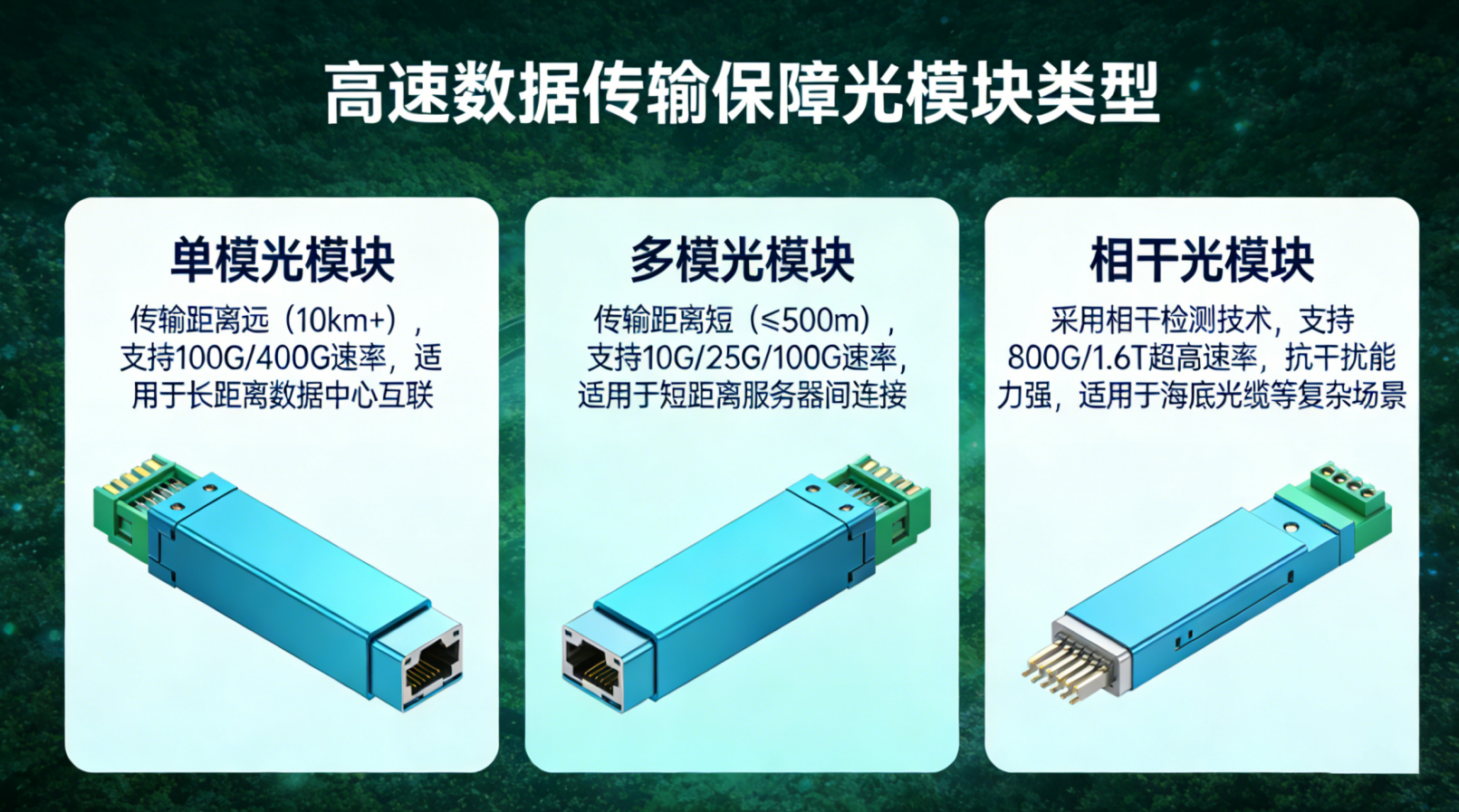

W jaki sposób długość fali, szybkość transmisji danych i odległość wpływają na wydajność

Wydajność i wykonalność wdrażania nadajników i odbiorników zależą naprawdę od trzech kluczowych czynników działających współbieżnie: długości fali, szybkości transmisji danych oraz odległości. Przy wyborze długości fali istotne znaczenie ma zgodność z typem światłowodu. Dla krótszych odległości powszechnie stosuje się falę o długości 850 nm w połączeniu z wielomodowym światłowodem, umożliwiającą np. transmisję sygnału 100G na odległość około 100 metrów. Natomiast dla dłuższych tras inżynierowie korzystają z fali o długości 1550 nm w połączeniu ze światłowodem jednomodowym, który pozwala przesyłać sygnały 400G na odległości do ok. 2 kilometrów. W miarę jak szybkość transmisji rośnie – od 400G aż do 800G – nieuniknionym staje się zastosowanie albo optyki koherentnej, albo zaawansowanych technik sygnalizacji PAM4. Jednak wiąże się to z określonymi kosztami: wzrostem poboru mocy oraz większą podatnością na problemy występujące w ścieżce transmisji. Czynnik odległości również nakłada dość rygorystyczne ograniczenia. Większość połączeń o zasięgu 80 km osiąga maksymalną przepustowość 200G z powodu problemów związanych z dyspersją chromatyczną oraz spadkiem poziomu szumów. Z drugiej strony, krótsze połączenia o zasięgu 10 km mogą rzeczywiście obsługiwać prędkości 800G, o ile zastosowane zostaną odpowiednie metody korekcji błędów (FEC) oraz kompensacja cyfrowego przetwarzania sygnału (DSP). Projektanci sieci w warunkach rzeczywistych poświęcają dużo czasu na balansowanie tych wzajemnie sprzecznych wymagań przy budowie systemów, które muszą być skalowalne i dostosowywać się do zmieniających się potrzeb rynku w czasie.

Kluczowe komponenty zasilające nowoczesne transceivery optyczne

Dioda laserowa, fotodetektory i procesory sygnału cyfrowego (DSP): umożliwienie szybkości i dokładności

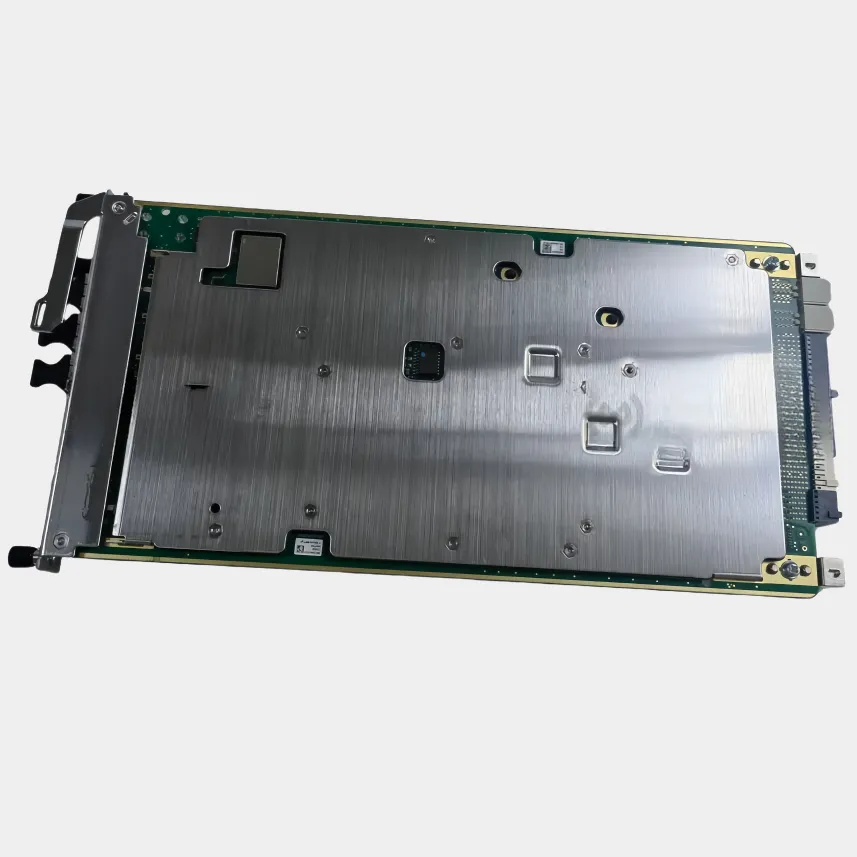

Współczesne transceivery optyczne zależą od trzech głównych elementów działających razem: diod laserowych, fotodetektorów oraz zaawansowanych procesorów sygnału cyfrowego, zwanych DSP. Diody laserowe generują stabilne i szybkie sygnały optyczne, zwykle przy użyciu technologii sprzężenia zwrotnego rozproszonego (DFB) lub nowoczesnych układów fotoniki krzemowej, co pozwala na minimalizację tłumienia sygnału podczas przesyłania danych przez kable światłowodowe. W przypadku fotodetektorów większość systemów wykorzystuje detektory typu PIN lub lawinowe, które przekształcają nadchodzące światło z powrotem w czyste sygnały elektryczne. Te detektory muszą charakteryzować się dużą czułością i niskim poziomem szumów, aby dane pozostawały nietknięte. Procesory DSP z kolei wykonują za kulisami wiele złożonych zadań, takich jak rzeczywistoczasowa korekcja sygnałów, odzyskiwanie sygnału zegarowego oraz dekodowanie poprawek kodu korekcji błędów (FEC), mających na celu naprawę wszelkich nieprawidłowości występujących podczas transmisji. Wszystkie te komponenty współpracują ze sobą, umożliwiając osiągnięcie imponujących współczynników błędów bitowych poniżej 1E-15 nawet na odległościach przekraczających 100 kilometrów. Nie należy również zapominać o deterministycznych wymaganiach dotyczących opóźnienia, które czynią te systemy niezbędny elementem współczesnych centrów danych o skali hiperwielkiej oraz wspierają rosnącą infrastrukturę sieci 5G.

Wyzwanie efektywności 400G+: balansowanie mocy, ciepła i przepustowości

Przekroczenie progu 400 G powoduje poważne problemy związane z nagrzewaniem się i poborem mocy. Za każdym razem, gdy szybkość przesyłania danych podwaja się, zapotrzebowanie na energię wzrasta o około 60–70 procent, co prowadzi do gromadzenia większej ilości ciepła w gęsto upakowanych portach przełączników. Bez odpowiednich środków zapobiegawczych nadmiarowe ciepło powoduje zniekształcenie sygnałów, przyspiesza zużycie komponentów i ostatecznie obniża niezawodność systemu. Przemysł opracował kilka podejść do rozwiązania tych problemów. Niektórzy producenci integrują chłodniki z mikrokanałami, inni wprowadzają adaptacyjne systemy zarządzania energią, które mogą zmniejszać zużycie energii o około 30 procent przy niskim natężeniu ruchu sieciowego. Coraz szerzej stosowana jest również technologia fotoniki krzemowej, która skraca długie połączenia elektryczne między komponentami, redukując jednocześnie utratę sygnału oraz generowanie ciepła. Na płaszczyźnie materiałów również obserwujemy postępy: lasery wykonane z fosforku indu, w porównaniu do tradycyjnych rozwiązań, charakteryzują się wyższą sprawnością zamiany energii elektrycznej na światło (wall plug efficiency). Wszystkie te osiągnięcia pozwalają współczesnym transceiverom obsługiwać moc do 400 watów na jednostkę rackową, utrzymując przy tym temperaturę wewnętrzną poniżej 50 stopni Celsjusza – co odpowiada standardom termicznym określonym przez IEEE i OIF dla ciągłej pracy w wysokiej prędkości.

Formy obudów i standardy: dopasowanie transceiverów optycznych do potrzeb infrastruktury

Wybór odpowiedniej formy obudowy zapewnia optymalną gęstość portów, zarządzanie ciepłem oraz współdziałanie w ramach rozwijającej się infrastruktury. Standardowe interfejsy mechaniczne i elektryczne — od SFP po QSFP-DD — umożliwiają kompatybilność typu plug-and-play oraz wspierają stopniowe ulepszania przepustowości bez konieczności pełnej modernizacji systemu.

SFP, QSFP, OSFP i QSFP-DD — skalowanie gęstości i prędkości od 1 G do 800 G

Moduły SFP są doskonałe do zapewniania prędkości od 1 G do 10 G w kompaktowych obudowach, które dobrze sprawdzają się w sieciach brzegowych oraz punktach dostępu, gdzie istotna jest oszczędność miejsca. Następnie mamy wersje QSFP, które integrują cztery kanały, co czyni je odpowiednimi do obsługi prędkości do 100 G w gęsto upakowanych przełącznikach stosowanych w większości nowoczesnych centrów danych chmurowych. Spoglądając w przyszłość, zarówno formaty OSFP, jak i QSFP-DD są w stanie spełniać ogromne wymagania dotyczące przepustowości – od 400 G aż do 800 G – dzięki swojej architekturze z ośmioma kanałami oraz lepszym rozwiązaniom zarządzania ciepłem. Te nowsze konstrukcje pozwalają faktycznie podwoić liczbę portów przypadających na jednostkę rackową w porównaniu do starszych standardów QSFP28. Zgodnie z najnowszymi wynikami prezentowanymi na konferencji OFC 2023, ten postęp pozwolił zmniejszyć zużycie energii przypadające na gigabit o około 30%, co znacznie ułatwia firmom modernizację istniejącej infrastruktury 100 G w kierunku tych nowoczesnych systemów 800 G zoptymalizowanych specjalnie pod kątem obciążeń związanych z sztuczną inteligencją i uczeniem maszynowym.

SR, LR, ER, ZR, DR, FR: Odczytywanie standardów zasięgu w kontekście rzeczywistych wdrożeń

Klasyfikacje zasięgu pomagają określić, czego możemy oczekiwać od różnych typów włókien światłowodowych na różnych odległościach. Krótki zasięg (SR) działa na odległościach poniżej 300 metrów przy użyciu światłowodów wielomodowych, które są często stosowane do łączenia urządzeń w ramkach lub na terenach kampusów. Długi zasięg (LR) umożliwia połączenia na odległość do 10 kilometrów za pomocą światłowodów jednomodowych, co czyni go idealnym rozwiązaniem dla sieci miejskich. Rozszerzony zasięg (ER) obejmuje jeszcze większe odległości – do około 40 km, podczas gdy zasięg dalekiego zasięgu (ZR) sięga aż 80 km. Dla tych dłuższych odległości wymagane są mocniejsze lasery oraz zaawansowane techniki korekcji błędów, aby zapewnić prawidłowe działanie w sieciach szkieletowych i kablowych połączeniach morskich. Ostatnio pojawiły się specjalizowane kategorie przeznaczone dla nowoczesnych centrów danych: Data Center Reach (DR) oraz Fiber Reach (FR). DR zwykle obejmuje łącza o długości 500 metrów między serwerami w architekturach typu spine-leaf, natomiast FR określa standardowe specyfikacje kompatybilne z różnymi typami światłowodów zgodnie z wytycznymi IEEE 802.3, zapewniając zgodność sprzętu pochodzącego od różnych producentów.