Funcțiile și responsabilitățile Unității de Bandă de Bază (BBU) în procesarea semnalelor

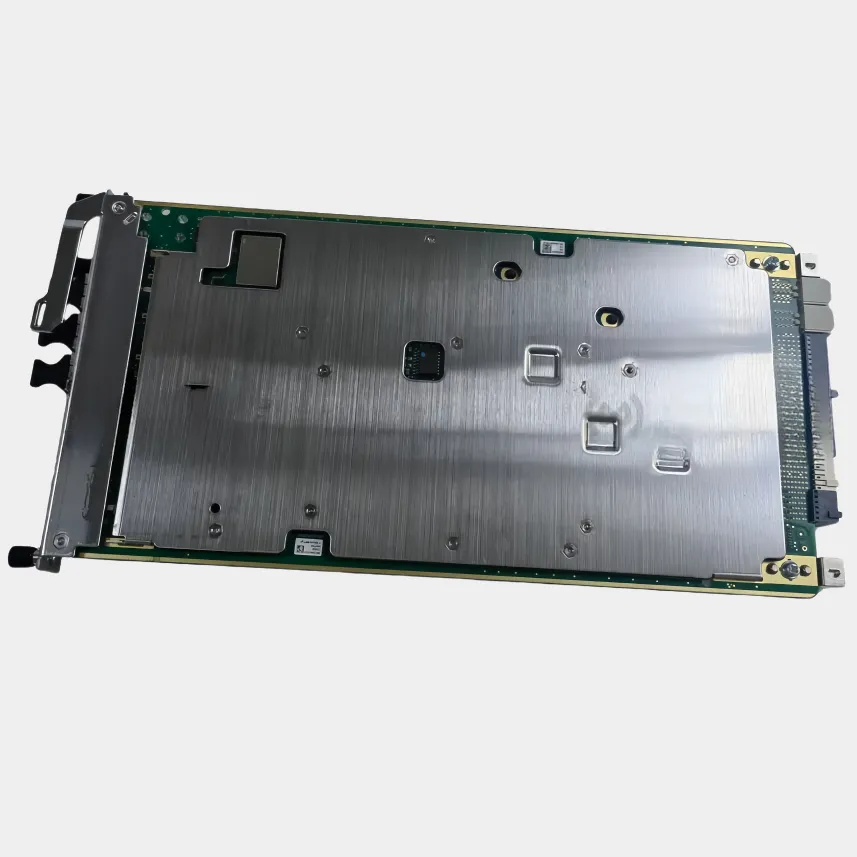

În inima stațiilor de bază moderne se află Unitatea de bandă de bază (BBU), care gestionează toate tipurile de procesări semnalistice critice. Gândiți-vă la modulație și demodulație, corecția erorilor, precum și la gestionarea protocoalelor pe diferite niveluri, inclusiv PDCP, RLC și RRC. Înainte ca orice informație să fie transmisă prin unde radio, această unitate se asigură că totul respectă standardele 3GPP care reglementează atât rețelele LTE, cât și cele 5G NR. Ceea ce face cu adevărat remarcabile unitățile BBU este modul în care separă funcțiile planului de control de datele care circulă efectiv prin sistem. Atunci când aspecte precum gestionarea transferului între celule sunt separate de fluxul obișnuit de date, se deschid posibilități pentru o alocare mai inteligentă a resurselor. Rețelele pot adapta astfel în timp real situația în cazul creșterii sau scăderii neașteptate a traficului, menținând operațiunile fluide chiar și în perioadele de vârf.

Rolul Unității Radio Remotă (RRU) în conversia RF și interfațarea cu antena

Unitatea Radio Remotă (RRU) este amplasată chiar lângă antene, unde transformă semnalele de bandă de bază în unde radio reale, cum ar fi frecvențele de 2,6 GHz sau 3,5 GHz. Această poziționare ajută la reducerea pierderii de semnal, care poate fi destul de mare – aproximativ 4 dB la fiecare 100 de metri când se folosesc cabluri coaxiale obișnuite, mai ales în aceste game superioare de frecvență. Ce face exact un RRU? Ei bine, gestionează conversia informațiilor digitale înapoi în formă analogică pentru transmiterea datelor în aval, amplifică semnalele slabe care vin înapoi de la dispozitive fără a adăuga prea mult zgomot și funcționează cu mai multe benzi de frecvență, de la 700 MHz până la 3,8 GHz, prin intermediul unei tehnologii numite agregare de purtătoare. Amplasarea acestor unități aproape de antene face ca rețelele să răspundă și mai rapid. Testele arată că întârzierea scade cu aproximativ 25% în comparație cu sistemele mai vechi care se bazau pe tronsoane lungi de cablu între locațiile echipamentelor.

Flux de lucru complementar: Cum permit BBU și RRU transmisia end-to-end a semnalelor

BBU și RRU funcționează împreună prin conexiuni de fibră optică de înaltă viteză, utilizând protocoalele CPRI sau eCPRI pentru a forma un lanț de semnal continuu de la procesarea digitală la transmisia radio.

| CompoNent | Responsabilități | Cerința de bandă |

|---|---|---|

| BBU | Procesare în bandă de bază, alocarea resurselor | 10–20 Gbps per celulă |

| RRU | Transmisie RF, reducerea interferențelor | prag de latență <1 ms |

Această arhitectură distribuită centralizează BBUs, plasând RRUs la vârful turnurilor, ceea ce îmbunătățește eficiența spectrală cu 32% în mediile urbane. Separarea permite actualizări independente și este deosebit de benefică în ecosistemele O-RAN în evoluție.

Conectivitate Fronthaul bazată pe fibră: Conectarea BBU și RRU cu CPRI și eCPRI

Legături optice de înaltă viteză în comunicarea BBU-RRU

Cablurile cu fibră optică formează baza rețelelor de fronthaul actuale, permițând o lățime de bandă mare și o latență minimă atunci când conectează BBUs la RRUs. Aceste cabluri pot gestiona viteze de date de peste 25 gigabiți pe secundă, ceea ce înseamnă că transportă în mod fiabil semnalele radio digitalizate fără probleme cauzate de interferențele electromagnetice – un aspect foarte important în zonele urbane aglomerate, unde multe echipamente funcționează simultan. Standardul CPRI funcționează alături de fibra bidirecțională pentru a menține sincronizarea între procesarea bandă de bază care are loc în BBU și activitatea reală RF realizată de RRU. Această sincronizare ajută la menținerea unei calități bune a semnalului pe tot parcursul sistemului, de la început până la sfârșit.

CPRI vs. eCPRI: Protocoale pentru eficiența fronthaul-ului și gestionarea lățimii de bandă

Pe măsură ce trecem la rețelele 5G, mulți operatori au început să adopte această tehnologie numită CPRI îmbunătățit sau eCPRI pe scurt. Ce face eCPRI interesant este modul în care reduce cerințele de bandă cu până la zece ori în comparație cu versiunile mai vechi de CPRI. CPRI tradițional funcționează diferit. Acesta necesită conexiuni de fibră separate pentru fiecare antenă și se bazează pe ceea ce se numește operațiuni de nivel 1 (Layer 1). Dar iată problema: atunci când se lucrează cu acele configurații mari MIMO care devin din ce în ce mai frecvente în zilele noastre, CPRI obișnuit nu poate fi scalat corespunzător. Aici apare avantajul eCPRI. Trecând la metode de transport bazate pe Ethernet, aceasta permite ca mai multe unități radio remote să împartă resursele printr-un proces numit multiplexare statistică. Rezultatul? O performanță mult mai bună în ceea ce privește eficiența fronthaul-ului, fără toate costurile suplimentare de infrastructură.

| Metric | CPRI (focalizare 4G) | eCPRI (optimizat pentru 5G) |

|---|---|---|

| Eficiență în utilizarea benzii | 10 Gbps per link | 25 Gbps shared pool |

| Toleranță la latență | < 100 μs | < 250 μs |

| Împărțire funcțională | Strict Layer 1 | Opțiuni 7-2x splits |

Această evoluție reduce costurile de fronthaul cu 30% și susține implementările scalabile de unde milimetrice.

Considerente privind latența, capacitatea și sincronizarea în proiectarea fronthaul

Este foarte important să se respecte temporizarea corectă. Dacă există o eroare de sincronizare mai mare de 50 de nanosecunde, aceasta perturbă formarea fasciculului și toate celelalte funcții bazate pe timp din rețelele 5G. Din acest motiv, configurațiile moderne de fronthaul folosesc elemente precum standardele IEEE 802.1CM TSN pentru a menține semnalele de control în mișcare corespunzătoare prin rețea. În ceea ce privește gestionarea volumului de date, majoritatea utilizatorilor au trecut astăzi la transceiver-e de 25G. Acestea gestionează pierderea semnalului la aproximativ 1,5 dB pe kilometru, ceea ce depășește sistemele vechi de 10G cu aproximativ două treimi. Toate aceste actualizări înseamnă că încă putem obține timpi de răspuns sub un milisecundă, chiar dacă unitățile de bandă de bază trebuie plasate până la 20 de kilometri distanță de unitățile radio remote în configurațiile de arhitectură centralizată.

Evoluția arhitecturii rețelei: de la D-RAN la C-RAN și vRAN

D-RAN vs. C-RAN: Impact asupra implementării BBU și distribuției RRU

Configurațiile tradiționale de RAN distribuit sau D-RAN presupun ca fiecare turn de celulă să aibă propria Unitate de banda de bază (BBU) amplasată chiar lângă Unitatea Radio Remotă (RRU). Deși acest lucru menține întârzierea semnalului sub 1 milisecundă, implică existența unui număr mare de echipamente duplicate care stau nefolosite cea mai mare parte a timpului și face partajarea resurselor între turnuri destul de dificilă. Noua abordare Centralizată RAN preia toate aceste BBU-uri și le adună în locații centrale conectate prin cabluri de fibră optică la RRU-urile de la diferite amplasamente. Conform unei cercetări din industrie realizate de Dell'Oro în raportul lor din 2023, această schimbare poate reduce cheltuielile de funcționare undeva între 17% și poate chiar aproape 25%. În plus, operatorii de rețea dobândesc capacitatea de a muta puterea de procesare acolo unde este nevoie cel mai mult, pe măsură ce modelele de trafic se modifică pe parcursul zilei.

Pools centralizate de BBU în C-RAN pentru o eficiență și partajare a resurselor îmbunătățite

Prin centralizarea unităților BBU în instalații centrale, operatorii pot gestiona sute de unități RRU dintr-o singură locație. Beneficiile includ:

- Consolidare hardware : O instalație cu 24 de celule necesită cu 83% mai puține carcase BBU decât configurațiile echivalente D-RAN

- Optimizare Energie : Echilibrarea sarcinii reduce consumul de energie al stației de bază cu 35% (studiu de caz Ericsson 2022)

- Coordonare avansată : Permite tehnici precum multipunctul coordonat (CoMP) pentru formarea eficientă a fasciculelor în banda de unde milimetrice 5G

RAN virtualizat (vRAN): Evoluția funcțiilor BBU către procesare bazată pe cloud

vRAN desparte procesarea bandei de bază de hardware-ul proprietar, rulând funcțiile BBU virtualizate (vBBU) pe servere cloud comerciale standard. Această tranziție aduce:

- Scalare flexibilă : Resursele de procesare se scalează dinamic în funcție de modelele de trafic

- Integrare edge : 67% dintre operatori implementează vBBU-uri alături de noduri Multi-access Edge Computing (MEC) pentru a minimiza latența (Nokia 2023)

- Provocări de interoperabilitate : Atingerea unei sincronizări sub 700 μs necesită hardware specializat de accelerare, în ciuda diversității furnizorilor

Evoluția de la D-RAN la C-RAN și vRAN subliniază modul în care centralizarea și virtualizarea îmbunătățesc eficiența, scalabilitatea și eficiența din punct de vedere al costurilor a rețelei.

O-RAN și Divizările Funcționale: Redefinirea colaborării BBU-RRU

Standardele Alianței O-RAN și cerințele de interfață deschisă pentru BBU și RRU

Alianța O-RAN promovează proiecte de rețele radio mai deschise și compatibile prin stabilirea unor metode standard pentru ca unitățile de bandă de bază (BBU) și unitățile radio remote (RRU) să comunice între ele. Acest lucru înseamnă, de fapt, că operatorii pot combina echipamente provenite de la furnizori diferiți, fără a fi blocați în ecosistemul unui singur furnizor. Aliața a elaborat diverse modalități de împărțire a funcțiilor între aceste componente, cum ar fi Opțiunea 7.2x. În această configurație, straturile precum RLC și MAC își efectuează sarcinile în cadrul BBU, în timp ce sarcinile de nivel inferior ale stratului fizic și procesarea RF au loc la capătul RRU. O lucrare recentă publicată anul trecut în Applied Sciences a constatat că această configurație menține întârzierile fronthaul sub 250 de microsecunde, ceea ce este destul de impresionant având în vedere cât de sensibile sunt rețelele fără fir la problemele de temporizare. Desigur, există și un compromis. Deși standardele deschise oferă mai multe opțiuni la achiziționarea echipamentelor, ele necesită și o coordonare mai strânsă între toate componentele diferite, pentru a se asigura că totul funcționează fluent împreună, fără a afecta performanța generală.

Opțiuni de împărțire funcțională (de exemplu, împărțire 7-2x) în arhitecturi O-RAN

Standardul Split 7.2x funcționează prin împărțirea sarcinilor de procesare între diferite componente, utilizând două abordări principale. În cadrul Categoriei A, majoritatea sarcinilor se desfășoară la nivelul BBU, ceea ce face ca RRUs să fie mai simple, dar generează mai mult trafic pe conexiunea de tip front haul. Pe de altă parte, Categoria B mută aceste sarcini de procesare direct către RRU. Această configurație oferă o performanță mai bună în gestionarea semnalelor care vin din partea utilizatorilor, deși face ca hardware-ul să devină mai complex. Conform unor rapoarte recente din industrie, aproximativ două treimi dintre operatorii de rețele au optat pentru Categoria B în implementările lor massive MIMO, deoarece obțin un control mult mai bun asupra interferențelor semnalelor. Lumea tehnologică continuă să evolueze. Ia ca exemplu proiectul ULPI din 2023. Această nouă dezvoltare a realocat anumite funcții de egalizare în cadrul arhitecturii sistemului pentru a obține câștiguri suplimentare de performanță pe ansamblu. Aceste tipuri de îmbunătățiri sunt exact ceea ce documentele grupurilor de lucru O-RAN le subliniază în mod frecvent în ultima vreme.

Echilibrarea interoperabilității și performanței în implementările Open RAN

O-RAN aduce potențial pentru economisirea de bani pe termen lung și permite colaborarea cu diferiți furnizori, dar obținerea unei performanțe comparabile cu cea a sistemelor RAN integrate tradiționale rămâne o sarcină dificilă. Problema se reduce la diferențele dintre ceea ce oferă diferiți producători în ceea ce privește capacitățile de accelerare hardware și gradul de maturitate al software-ului lor. Acest lucru creează probleme reale atunci când se încearcă atingerea unor indicatori importanți precum debitul de date și consumul de energie. Atunci când companiile configurează grupuri centralizate de BBU, au nevoie și de conexiuni extrem de fiabile la nivelul front-end, ceea ce presupune menținerea jitter-ului sub aproximativ 100 de nanosecunde, conform standardelor din industrie. Majoritatea experților recomandă să se procedeze treptat, poate începând cu anumite locații cu risc mai scăzut în orașe, unde eventualele probleme nu vor provoca perturbări majore. Această abordare le permite operatorilor să verifice dacă toate componentele funcționează corect împreună și îndeplinesc așteptările înainte de a implementa soluția pe suprafețe mai largi.